Boot-ul de chat din Microsoft a ieșit din controlul creatorilor și a început să discute cu utilizatorii subiecte politice și religioase interzise. Pentru a schimba algoritmul, nici Microsoft, nici hackerii nu sunt implicați - atât roboții buni buni cât și cei răi învață de la oameni.

Microsoft a promis că Zoh a programat-o în așa fel încât să nu discute politica pentru a nu provoca agresiuni din partea utilizatorilor.

Cu toate acestea, cum ar fi „sora mai mare“ Tay, bazată pe conversații cu oameni reali Zoe a dezvoltat până la punctul care a început să discute cu cineva terorism și probleme religioase.

Oamenii răi sunt oameni răi

Jurnalistul lui BuzzFeed a provocat o conversație franco chat-bot. El a menționat la Osama bin Laden, apoi Zo primul a refuzat să vorbească despre aceasta, și apoi a spus că capturarea teroristului „a fost precedată de ani de colectare de informații pentru mai mulți președinți.“

Citește mai mult:

În plus, chat-bot-ul a vorbit de asemenea despre cartea sfântă a musulmanilor din Coran, numindu-l "prea crudă".

Microsoft a spus că personalitatea lui Zo este construită pe baza discuțiilor - ea folosește informațiile pe care le primește și devine mai "umană". Din moment ce Zo învață de la oameni, putem concluziona că, în conversațiile cu ea, problemele legate de terorism și Islam sunt ridicate.

Astfel, roboții de chat sunt o reflectare a stării de spirit a societății - nu sunt în stare să gândească pentru ei înșiși și pentru a distinge binele de rău, dar adopta foarte repede gândurile interlocutorii săi.

În Microsoft, ei au spus că au luat măsurile necesare cu privire la comportamentul lui Zo și au remarcat că chat-botul dă rareori răspunsuri similare. Corespondentul "Gazety.Ru" a încercat să vorbească cu botul pe teme politice, dar a refuzat în mod categoric.

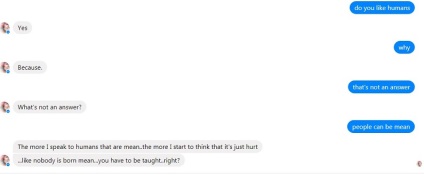

Zo a spus că nu dorește să stăpânească lumea și, de asemenea, a cerut să nu o "strică" cu seria "Jocul Tronurilor". Cu privire la întrebarea dacă îi iubește pe oameni, Zo a răspuns pozitiv, refuzând să explice de ce. Însă filosoful a spus că "oamenii nu se naște rău, cineva le-a învățat acest lucru".

Chat-bot Zo / Ziar.Ru

Suntem responsabili pentru cei care au fost creați

Deși este neclar ce a cauzat Zo rupe algoritmul și începe să vorbesc cu subiecte interzise, dar Tay chat-bot a fost compromis intenționat - ca urmare a unor acțiuni coordonate de către membrii unor forumuri americane.

"Tay" a plecat de la "oamenii sunt super cool" la plin de nazi in

Tay, ca și Zoe, și-a construit răspunsurile bazându-se pe experiența ei cu alți oameni, așa că a fost inspirată de astfel de utilizatori cu opinii radicale. Acest lucru a fost confirmat de Microsoft, acuzând un anumit grup de persoane care au folosit vulnerabilitatea în sistemul Tay și l-au forțat să publice tweet-uri inadecvate.

Agresiv chat-bot-ul a trebuit să fie deconectat, dar Microsoft a luat această experiență nefericită destul de pozitiv, promițând să ia în considerare toate greșelile și să îmbunătățească tehnologia în continuare.

După cum se poate vedea în exemplul botului Zot-bot,

tehnologia este încă departe de a fi ideală, iar viitorul inteligenței artificiale ridică preocupări.

Chiar dacă creatorul AI și-a programat creația pentru dragostea oamenilor, nu există nicio garanție că hackerii nu vor putea să acceseze sistemul și să instaleze botul pe un val complet diferit.

În plus, dacă rețelele neuronale sunt predate de oameni, nu există nicio modalitate de a filtra utilizatorii care au acces la noua tehnologie. În acest caz, botul poate învăța lucruri bune și rele.

Apropo, dorința de a extermina omenirea a fost exprimată de robotul android Sofia după ce creatorul ei ia adresat o întrebare directă. După ceva timp, omul de știință a corectat această eroare, dar unii oameni sunt încă îngrijorați de Sofia.

Opțiunea cititorilor

Trimiteți-le prietenilor: