H (A) = log la = log16 = 4 [bit / simbol]

Hmax (A) = log22 = 4,4594 [bit / simbol]

2. Arrays de conducte (CMR, ILC, CMO) și relația lor

Matricea canalului determină efectul interferenței pe un canal discret.

Matricele de canale sunt de trei tipuri: matricea sursă a canalului, matricea canalului receptorului și matricea canalului combinării.

Channel source matrix (IMR)

Matricea sursă a canalului constă în probabilitățile condiționate ale semnalelor recepționate în raport cu semnalele transmise, care reflectă efectul interferenței asupra canalului.

Această matrice reflectă caracteristicile statistice ale acțiunii de interferență. Matricea sursei de canal este matricea tranzițiilor directe ale semnalelor transmise către semnalele recepționate.

Fiecare linie a CMR reprezintă distribuția probabilităților condiționale ale semnalelor recepționate în raport cu semnalele transmise. Toate aceste probabilități condiționale p (bj / ai) formează KMI.

Matricea canalului receptorului (CMS)

Canalul discret este specificat complet dacă sunt cunoscute probabilitățile necondiționate de recepție a semnalelor și este specificată matricea canalului receptorului.

Probabilitățile condiționale p (ai / bj) de recepție a semnalelor cu privire la semnalele transmise formează matricea receptorului canalului (CMS) și reflectă efectul de interferență asupra canalului.

Matricea canalului combinat (MSC)

Canalul discret este specificat complet de matricea combinată canal (CMO).

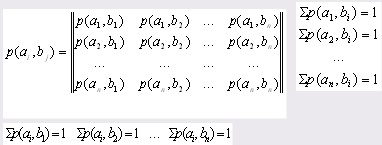

OCP constă în probabilitățile comune ale apariției semnalelor și - p (ai, bj) și reflectă efectul de interferență asupra canalului de comunicare.

Elementele matricei sunt probabilități comune:

Relația matricelor canalului

Proprietățile matricei sursă a canalului (IMR):

KMI este o matrice pătrată, adică dimensiunea ei este nxn;

Suma probabilităților condiționale ale fiecărui rând este de 1, adică se formează un grup complet:

Probabilitățile condiționale ale diagonalei CMR principale reflectă probabilitatea recepționării corecte a semnalelor în raport cu semnalele transmise;

Probabilitățile condiționale rămase ale matricei canalului (cu excepția diagonalei principale) reflectă probabilitatea recepției false a semnalelor transmise;

Pentru un canal ideal care nu are interferențe, matricea canalului are forma:

Proprietățile matricei canalului receptor (CMS):

CMP este o matrice pătrată, adică dimensiunea ei este nxn;

Suma probabilităților condiționale ale fiecărei coloane este de 1, adică se formează un grup complet:

Probabilitățile condiționale ale diagonalei principale a CMP reflectă probabilitatea de a primi în mod corect semnale în raport cu semnalele transmise;

Probabilitățile condiționale rămase ale matricei de canal a receptorului (cu excepția diagonalei principale) reflectă probabilitatea recepției false a semnalelor transmise;

Pentru un canal ideal care nu are interferențe, CMP arată astfel:

Proprietățile matricei care combină canalul (MSC):

Suma probabilităților comune ale fiecărui rând este egală cu probabilitatea necondiționată a sursei:

discrete cod de receptor de matrice

Suma probabilităților comune ale fiecărei coloane este egală cu probabilitatea necondiționată corespunzătoare a receptorului:

Suma tuturor elementelor matricei de canal a uniunii este 1.

3. Caracteristicile informației sursei de mesaje

Pentru a înțelege caracteristicile de informare, trebuie mai întâi să definiți termeni precum alfabetul mesajelor, o mulțime de simboluri comandate unice și un ansamblu de mesaje discrete (DAS).

Alfabetul unui mesaj este caracterele care sunt incluse în mesaj. De exemplu:

O tuplă de simboluri comandate unic este o secvență ordonată de simboluri.

X = - mesaj - un tuplu de caractere

Ansamblul mesajelor discrete (DAS) este un mesaj cu probabilitățile simbolurilor DAS

3.1 Numărul de informații sursă

Numărul de informații din simbolul mesajului este determinat de:

I (ai) = - log2 (p (ai)) = - log (p (ai)

În teoria de informații a lui Shannon, cantitatea de informație sursă este determinată de probabilitatea apariției unui simbol.

I (ai) = - ln (p (ai)) [nat]

I (ai) = - log (p (ai)) [punct]

Fiecare simbol al mesajului conține cantitatea proprie de informații.

Sursa informațiilor sursei de informații a sursei

1. Cantitatea de informații nu este negativă:

2. Cu cât este mai mare probabilitatea, cu atât mai puțin cantitatea de informații conține simbolul.

3. Dacă probabilitatea simbolului este 1, atunci cantitatea de informații a acestui simbol este 0.

p (ai) = 1 → I (ai) = 0

4. Additivitatea. Cantitatea de informații a mai multor simboluri este egală cu suma sumelor informative ale fiecărui simbol.

I (a1, a2, a3) = l (al) + I (a2) + I (a3)

Entropia este suma medie a informațiilor pe simbol de mesaj (media ponderată).

1. Entropia nu este negativă: H (A) ≥ 0

2. Entropia este zero dacă și numai dacă probabilitatea simbolului este 1: H (ai) = 0 ↔ p (ai) = 1

3. Entropia este limitată: H (ai) ≤ log n [bit / simbol]

unde n este numărul de caractere din mesaj.

4. Entropia maximă este egală cu: Hmax (A) = log n [bit / simbol]

3.2 Pierderi de informații

Există două tipuri de entropie condiționată, care determină efectele interferenței pe un canal discret - aceasta este o entropie condiționată specială (CSE) și o entropie condițională generală (SEE).

Entropia parțială condiționată a sursei (MTSI) a mesajelor afișează cantitatea de pierdere de informații din transmisia fiecărui semnal ai:

H (B / ai) = - p (bj / ai) log p (bj / ai)

Entropia condiționată generală a sursei (FEC) determină pierderea medie a cantității de informații per semnal primit în raport cu semnalele transmise.

4. Caracteristicile de informare ale receptorului de mesaje

4.1 Numărul de informații despre destinatar

Numărul de informații din simbolul mesajului este determinat de:

I (bj) = - log2 (p (bj)) = - log (p (bj)

În teoria informației Shannon, cantitatea de informații a receptorului este determinată de probabilitatea apariției unui simbol.

I (bj) = - ln (p (bj)) [nat]

I (bj) = - log (p (bj)) [punct]

Fiecare simbol al mesajului conține cantitatea proprie de informații.

Proprietățile numărului de informații despre destinatarul mesajelor

1. Cantitatea de informații nu este negativă: I (bj) ≥ 0

2. Cu cât este mai mare probabilitatea, cu atât mai puțin cantitatea de informații conține simbolul.

3. Dacă probabilitatea simbolului este 1, atunci cantitatea de informații a acestui simbol este 0.

p (bj) = 1 → I (bj) = 0

4. Additivitatea. Cantitatea de informații a mai multor simboluri este egală cu suma sumelor informative ale fiecărui simbol.

I (b1, b2, b3) = I (b1) + I (b2) + I (b3)

Entropia este suma medie a informațiilor pe simbol de mesaj (media ponderată).

1. Entropia nu este negativă:

2. Entropia este zero dacă și numai dacă probabilitatea simbolului este 1:

H (ai) = 0 ↔ p (ai) = 1

3. Entropia este limitată

H (B) = unde n este numărul de caractere din mesaj. 4. Entropia maximă este Hmax (B) = log n [bit / simbol] 4.2 Pierderea informațiilor Există două tipuri de entropie condiționată, care determină efectele interferenței pe un canal discret - aceasta este o entropie condiționată specială (CSE) și o entropie condițională generală (SEE). O entropie condiționată particulară a receptorului (SIP) a mesajelor determină pierderea de informații a fiecărui semnal recepționat. H (A / bj) = - p (ai / bj) log p (ai / bj) (j = 1,2 ... n) Entropia condiționată generală a receptorului (OCEP) determină pierderea medie de informații pe simbol atunci când ansamblul este primit: 5. Caracteristicile vitezei 5.1 Rata de modulare [simbol / sec] unde este durata transmiterii unui semnal Dacă durata transmiterii semnalelor este diferită, se calculează timpul mediu de transmisie al unui semnal. 5.2 Performanța sursei baud; Capacitatea sursei este numărul de biți produs pe unitate de timp - 1 secundă. 5.3 Viteza de transmisie sau baud; Rata transferului sursei: Viteza de transmisie a receptorului: 5.4 Capacitatea canalului sau baud; Capacitatea canalului (capacitatea canalului) este maximul numărul de biți transmise pe unitate de timp - al doilea. Lățimea de bandă este rata maximă de transfer. Capacitatea canalului sursă: Capacitatea canalului receptorului: 5.5 Coeficient de eficiență al unui canal discret Cu cât coeficientul de eficiență al unui canal discret tinde spre unitate, cu atât este mai eficient canalul și cu atât mai puține sunt pierderile de informații de pe acesta. 5.6 Teoremele lui Shannon privind viteza critică și codificarea Teorema de viteză critică: Teorema determină rata de transmisie critică, în funcție de distribuția probabilității, la care există o metodă de transmisie cu o viteză R (), la care este posibilă restaurarea mesajului original (), unde C este capacitatea canalului, H (A) este entropia sursei; Teorema de codare: Dacă H '(A) - performanța sursei - este mai mică decât capacitatea canalului (), atunci există o metodă de codare și decodare, la care probabilitatea de eroare va fi arbitrar mică și invers. Un exemplu de calcul al caracteristicilor de viteză pentru o matrice sursă de canal. 1. Date de fond Se dă o matrice de probabilități condiționale care reflectă efectul de interferență al unui canal de comunicare discret. Suma probabilităților fiecărui rând este de 1,00. Timpul de transmitere a simbolului este τ = 0,0002 sec. Au fost trimise 250 de caractere. Probabilitatea necondiționată de apariție a simbolurilor la ieșire: p (a1) = 0,25, p (a2) = 0,35, p (a3) = 0,15, p (a4) 1) Cantitatea de informație I (ai) a fiecărui simbol a1, a2, a3 al mesajului discret: 2) Cantitatea medie de informații transmise de un simbol determină entropia sursei mesajelor H (A): H (A) = - (0,25 * (- 2) + 0,35 * (- 1,51) + 0,15 * (-2,73) + 0,25 * 0,5 - 0,53 - 0,41 - 0,5) = 1,94 [bit / simbol] 3) entropia maximă a sursei de mesaje Hmax (A) Hmax (A) = log N = log 4 = 2 [bit / simbol] unde N este numărul de caractere din alfabetul mesajului. 4) Pierderea informației în transmisia fiecărui simbol ai determină entropia condiționată particulară H (B / ai): -(-0.11368 - 0.2161 - 0.1518 - 0.1129) = 0.6175 [bit / simbol] -(-0,3321 - 0,2112 - 0,2435 - 0) = 0,787 [bit / simbol] -(-0 - 0.0664 - 0.0286 - 0.0664) = 0.1614 [bit / simbol] H (B / a4) = - (0 + 0 + 0,01 * (-6,64) + 0,99 * (-0,0145) -(-0-0 - 0,0664-0,0144) = 0,081 [bit / simbol] 5) Pierderi medii de informatie in transmisia unuia Informația este numită proces care provine din stabilirea unei legături între două obiecte ale lumii materiale: sursa. sau generatorul de informații și receptorul acestuia sau destinatarul. Teoria informației ca știință, subiect și metode de studiu, aplicație în tehnologia informatică. Sisteme de transmitere a informației, tipuri de mesaje și sursele acestora. Tipuri de interferențe și modalități de a le elimina. Echipamente utilizate în transmiterea datelor. Concepte și definiții de bază ale codării informațiilor. Combinația de coduri și lungimea acestora. Clasificarea codurilor pe diferite motive, metode de prezentare, scop. Reprezentare sub formă de arbori de cod sau polinoame, matrice și geometrice. Bit, incertitudine, cantitate de informații și entropie. Formul lui Shannon. Formula lui Hartley. Logaritmi. Cantitatea de informații primite în timpul mesajului. Interacțiunea sursei și a receptorului de informații. Numărul, capacitatea de informare a celulelor de memorie. Bazele teoriei transferului de informații. Studiul experimental al aspectelor cantitative ale informațiilor. Cantitatea de informații despre Hartley și C. Shannon. Caracteristicile de frecvență ale mesajelor text. Cantitatea de informații ca măsură a incertitudinii eliminate. Codificare optimă statistică (economică). Concepte și definiții de bază ale teoriei codării. Principii de construire a codurilor optime. Abilitatea sistemului de a primi informații în prezența unor interferențe. Măriți puterea semnalului. Manual pentru elevi și profesori. Mecanismul transferului de informații, numărul și criteriile de măsurare. Unități de informații, în funcție de baza logaritmului. Proprietățile de bază și caracteristicile cantității de informații, entropia sa. Determinarea entropiei, redundanța mesajelor de informare. Sursa (transmițătorul) și receptorul (receptorul) servesc pentru schimbul de informații. Într-un caz, expeditorul și destinatarul informațiilor servește Programul pentru caracteristicile rozrawnku informatsionnyh ale canalului zvoyazyku. Codul Pobudova pentru transmisie. Procedura koduvannya, decoduvania că otsynka efektivnosti kodiv. Programul de pe algoritmul maus Pascal. Matricea canalului, care este viznacha vtrati informație. Caracteristicile calculului cantității de informații obținute prin schimbarea de fază a unui semnal, dacă este cunoscută amplitudinea acestuia. Calculul caracteristicilor informaționale ale surselor de mesaje discrete și ale unui canal discret. Caracteristicile aplicării eșantionării și cuantificării. Schema generală a funcționării canalelor de comunicare, clasificarea și caracteristicile acestora. Un canal de comunicare discret, binar și determinarea tranziției lor, trăsături ale acțiunii cu și fără interferență, prin teorema lui Shannon. Capacitate continuă a canalului. 2.2.2. Criteriul de informare pentru evaluarea incertitudinii fonetice. În semn de recunoaștere a limbii vorbite ar trebui să depună eforturi pentru a se asigura că toate foneme clasificate în mod corect, așa că suntem interesați în recunoașterea deplină a secvenței de unități fonetice care alcătuiesc declarația. Numărul total de mesaje care nu se repetă. Calculul ratei transferului de informații și a capacității canalelor de comunicare. Determinarea redundanței mesajelor și codarea optimă. Procedura de construire a codului optim folosind tehnica Shannon-Fano. Sub este același cu funcția, dar nu returnează o valoare, ci produce o acțiune. De exemplu, afișarea mesajelor pe ecran sau manipularea mai multor proprietăți. Generarea unui polinom generator pentru un cod ciclic. Conversia matricei de generatoare într-o matrice de testare și invers. Calcularea distanței de cod pentru codul blocului linear. Generarea unei tabele de dependență a vectorilor de eroare de sindromul pentru codurile binare. Procesarea unor cantități mari de informații cu ajutorul unui computer nu poate fi organizată eficient numai prin îmbunătățirea mijloacelor tehnice - creșterea capacității de memorie, scurtarea timpului de acces la mediile externe etc. Soluții de sarcini tipice în domeniul telecomunicațiilor. O analiză a probabilității intrării în sistem de către un atacator cu una sau trei încercări. Probabilitățile de conectare pentru o lungime probabilă fixă și aleatorie. Investigarea și calcularea siguranței (fiabilității) metodei atunci când se păstrează. Optimizarea lungimii eșantionului. Asociația este o colecție de mai multe ansambluri de evenimente discrete și aleatorii. Entropia necondiționată este cantitatea medie de informație pe simbol. Descrierea proprietăților informaționale ale unei surse continue. Conceptul de entropie diferențială.

Articole similare

Trimiteți-le prietenilor: