Până în prezent, motoarele de căutare - aceasta este una dintre cele mai simple și eficiente modalități de a găsi rapid răspunsul la o întrebare interesantă, de a afla cele mai recente știri sau de a cumpăra un produs foarte greu de găsit în rețeaua de vânzări. Dar să ne uităm la motorul de căutare prin ochii proprietarilor de resurse web. Există destul de înaltă calitate și site-uri utile pentru care utilizatorul pur și simplu vine de la faptul că acestea sunt aproape și nu se încadrează în top 10 sau chiar 50 de top rezultatele căutării.

Uneori și resursele optimizate perfect cu evaluări excelente și nivelul de încredere al motoarelor de căutare pot fi clasate destul de rău. Unul dintre principalele motive pentru aceasta este prezența unui număr mare de duplicate și a paginilor "inutile" (în ceea ce privește motoarele de căutare) din index.

Instrumentul principal și cel mai optim pentru a trata duplicatele a fost întotdeauna standardul robots.txt. Scopul său principal este de a exclude paginile nedorite din index, ceea ce este foarte important pentru promovarea eficientă și eficientă a site-ului în motoarele de căutare. Nu vom trăi în detaliu descrierea teoretică a scopului și a sintaxei acestui fișier. Acest lucru poate fi citit pe resursele tematice în limba engleză și în limba rusă. Vom examina mai îndeaproape aspectul practic al aplicării acestui standard atunci când îl promovăm în motorul de căutare Google.

- Interzicerea indexării paginilor, fișierelor și directoarelor individuale.

- Abilitatea de a configura permisiunea de a indexa fișierele individuale dintr-un director care este închis de la indexare (specificând directiva "Permiteți" după directiva corespunzătoare "Disallow").

- Simplitatea utilizării în comparație, de exemplu, cu meta-tag (trebuie specificat pe fiecare pagină pe care doriți să o închideți din indexare, în timp ce fișierul robots.txt vă permite să închideți directoare întregi).

- Abilitatea de a închide întregul site de indexare prin specificarea directivei "Disallow: /" (închiderea versiunii de test înainte de lansarea site-ului actualizat).

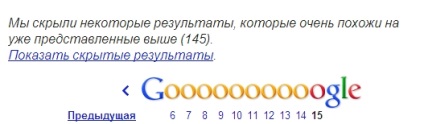

Apăsați în indexul secundar

Paginile, închise de la indexare, cel mai probabil, intră încă în indexul Google. În special, aceste pagini pot fi găsite în indexul de sub al motorului de căutare, ceea ce face o cerere prin intermediul «site-ul meu .com» operator „Afișați rezultatele ascunse“ și făcând clic pe

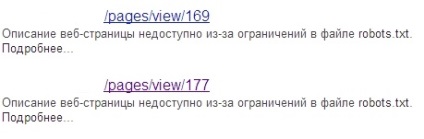

Astfel de pagini din index vor avea o descriere corespunzătoare sub linkul lor:

După cum se știe, prezența unui număr mare de pagini din index secundar - acesta este un site de indexare lent de la Google, precum și reducerea pozițiilor în rezultatele de căutare, datorită faptului că pe site-ul, în conformitate cu un motor de căutare, există multe „inutili“ pentru paginile de utilizator, etc. . n.

Citirea incorectă a fișierului de către motorul de căutare

Un alt dezavantaj semnificativ este că Google poate citi în mod incorect informațiile din fișierul robots.txt. Din această cauză, paginile normale pot intra și într-un index secundar.

De exemplu, aici sunt directivele specificate în fișierul robots.txt al site-ului, A:

Dar situația observată în indexul Google când este solicitat de operatorul "site":

În primul rând. Cu ajutorul operatorului "site", verificați întotdeauna dacă aveți paginile necesare în indexul principal. În al doilea rând. utilizați următoarele metode pentru a împiedica indexarea paginilor individuale.

- Specificați în bloc meta tag

] " lt; meta nume = laquo; roboți raquo; conținut = laquo; noindex. nofollow raquo; gt;

] " lt; meta nume = laquo; roboți raquo; conținut = laquo; noindex. urmări raquo; gt;

Dezavantajul acestei metode este că paginile pe care este înregistrat acest meta-tag. nu întotdeauna închise de la indexare. Există momente când conținutul acestor pagini este indexat cu succes de Google. În acest caz, "pentru a vă asigura" puteți recurge la altă metodă, care este descrisă mai jos.

Acest lucru funcționează bine nu numai pentru preluarea completă a paginilor (de exemplu versiunile de tipărire), ci și pentru duplicate parțiale. De exemplu, site-ul are mai multe pagini pentru același produs, prezentat în diferite variante de culoare. În acest caz, opțiunea optimă va alege una dintre paginile principale (de exemplu, produsul în cea mai populară culoare), iar în paginile rămase din atribut indicați-o ca fiind canonică.

Cu acest instrument, puteți șterge nu numai o anumită pagină din indexul Google, ci și toate paginile din acest director, imagini specifice sau chiar întregul site. Singurul sfat: citiți cu atenție recomandările Google pentru utilizarea sa.

- "Bind" duplicate cu cea de-a 301-a redirecționare a serverului

Recent, paginile noi după cea de-a 301-a redirecționare sunt indexate timp de 1-3 zile de la data trimiterii cererii. Singurul nuanț: este mai bine să nu închideți paginile vechi de la indexare, deoarece atunci robotul de căutare nu poate ajunge pe ele și "lipsește" cu pagina de care avem nevoie.

- Utilizați http-header rel = "canonical"

Aplicarea acestei metode va fi optimă pentru diferite tipuri de fișiere cu diferite extensii. pdf. xls și altele.

În concluzie, observ că problema luptei cu dublurile a fost întotdeauna și este relevantă pentru orice specialist SEO. Deci, nu vă fie frică să experimentați, să utilizați diferite opțiuni pentru a lupta cu duble, pentru a evalua rezultatele și pentru a trage concluzii bazate pe practică, și nu pe teorie goală.

Și există o modalitate de a elimina masiv din paginile de index Google interzise în robots.txt (au lovit indexul suplimentar)? A înregistrat pentru ei, dar ei deja mai mult de o lună toate la fel pentru a păstra într-un index. Ștergeți unul câte unul manual pentru prea mult timp. A le da o greșeală de 404 este într-un fel o ideologie greșită. Există o metodă de lucru?

Cel mai probabil, după ce v-ați înregistrat pentru aceste pagini, robotul Google nu a ajuns încă la acestea și, în consecință, nu știe încă că este închis de la indexare.

Dacă le-a indexat după ce le-ați închis cu roboți, dar sunt încă în indexul principal, atunci ați făcut ceva greșit.

Dacă nu există multe astfel de pagini, încercați să le ștergeți manual prin GWT. Sau configurați redirecționarea site-ului 301 în pagina de pornire cu toate intrările inexistente.

301 acasă este plină!

manual, deci este întotdeauna necesar să ștergeți (și nu eficient)!

Dacă aveți metode care vor rezolva cât mai eficient problema descrisă mai sus, atunci le puteți partaja cu toți oamenii cinstiți :)

Nu cred că sa întâmplat ceva în neregulă. O modalitate mai eficientă - este de a înregistra rel = canonic pe aceste pagini, este Googlebot mai bine și mai receptiv decât pe meta Robots (principalul lucru pe care, după propisaniem Canonical Googlebot a văzut pagina).

Vladislav, despre faptul că după închiderea în roboți a paginii este încă în index - deci aceasta este o practică veche. Într-adevăr, lucrând ca un optimizator, nu văd problema. Există chiar și în partea de sus pentru unele cereri sunt paginile închise în roboți! Și, după cum credeți, acest webmaster a făcut ceva greșit. Sau poate, în același timp, recoacerea Google.

Din nefericire, din numărul în creștere de 404 de neînțeles și suferim :(

Ele nu par clar în cazul în care și în condiții de siguranță indexate, în timp ce văd o singură cale - de a verifica și remedia manual în GWT.

301 la principal cu toate inexistente. Vladislav, citește articolul, poate puțin mai clar pentru tine va fi promovarea SEO:

Trimiteți-le prietenilor: