Bună ziua tuturor, prieteni! Astăzi vă voi spune cum să creați un fișier txt robots pentru wordpress. Această postare va fi foarte importantă pentru cei care nu au încă un fișier txt robots. Voi încerca să-ți spun comenzile de bază care sunt utilizate în acest fișier, astfel încât să puteți face dvs. de roboți proprii txt și arată un exemplu de ceea ce ar trebui să fie robots.txt corectă pentru WordPress.

Dar cel mai groaznic lucru este că mulți dintre cei nou-veniți nu suspectează nici măcar că pot avea conținut dublu pe blogul lor. După crearea unui blog, ei încep să scrie articole pentru ei înșiși. Scrie, scrie, apoi din nou, iar paginile zboară din index. Apoi se gândesc, de ce site-ul meu a ajuns sub AGS. Am scris articole interesante, unice pentru oameni. Blogul meu este bun pentru oameni. Da, poate este adevărat și înțeleg, dar robotul de căutare, din păcate, nu este.

Înainte de a vă arăta cum să creați un fișier robots txt pentru wordpress, să ne gândim unde poate proveni un site duplicat.

Acestea sunt două pagini diferite pentru crawler, iar ultima, trebuie să închideți indexarea. Cum să procedez corect, o să-ți explic ceva mai târziu.

Ei bine, în general, acum vă voi arăta robots.txt corect pentru wordpress, care este pe site-ul meu. Iată un exemplu de robot txt:

atunci trebuie doar să eliminați fișierul robots.txt din această linie

Dezactivați: / *? *. deoarece blochează indexarea tuturor paginilor în care apare semnul de întrebare "?". Trebuie să fie curățată în două locuri.

Cum de a face tu robots.txt dreapta?

Dacă aveți un alt sistem de gestionare a site-urilor, vă voi spune pe scurt comenzile de bază, astfel încât să puteți compila robots.txt pentru site-ul dumneavoastră. Deci, hai să mergem.

Directiva "User-agent" este responsabilă pentru ce motor de căutare accesați.

- User-agent: * - la toate motoarele de căutare;

- User-agent: Yandex - numai la Yandex;

- Agent de utilizator: Googlebot - numai la Google;

Dacă doriți să închideți întregul site de la indexarea de către Google, atunci trebuie să scrieți acest lucru:

Și dacă, dimpotrivă, doriți ca întregul site să fie indexat de Google, atunci trebuie să scrieți următoarele în fișierul robots.txt:

Astfel, putem interzice indexarea unui site sau a unei pagini, Yandex și buzz separat, sau tuturor motoarelor de căutare simultan.

Directiva Sitemap vă permite să specificați o hartă a site-ului pentru roboții de căutare:

Există mai multe directive, pe care numai Yandex le înțelege.

Directiva privind întârzierea accesării cu crawlere vă permite să specificați întârzierea cu care crawlerul vă va trimite o comandă. Dacă aveți un site mare, atunci motorul de căutare prin studiul său constant poate crea o sarcină mare pe server. Și pentru ca acest lucru să nu se întâmple, puteți utiliza directiva "întârzierea accesării cu crawlere"

De exemplu:

Aceasta înseamnă că intervalul dintre trimiterea comenzii va fi de 3 secunde. Dar, din nou, acest lucru este relevant numai pentru Yandex.

- Simbolul * este orice secvență de caractere.

- Caracterul $ este sfârșitul liniei.

Voi explic acum ce înseamnă acest lucru și cum să folosiți aceste caractere atunci când construiți un fișier robots.txt

În primul rând, vom afla cum să folosim "*". De exemplu, am o pagină duplicată

Pentru al elimina din index, trebuie să scrieți următoarele:

Deci, spun robotului de căutare: "Dacă vedeți semnul întrebării"? "În URL-ul paginii, atunci nu îl indexați. Și nu contează care personaje stau în fața semnului de întrebare și după el. "

Pentru ca inainte de semnul intrebarii si dupa aceea am pus un asterisc "*". Și, la rândul său, înseamnă orice succesiune de simboluri.

Ei bine, acum să ne uităm la modul de utilizare a caracterului $. De exemplu, avem o astfel de pagină de apă

și vrem să interzicem robotul de căutare să îl indexeze.

Pentru a face acest lucru, scrieți următoarele

Prin urmare, cunoscând numai aceste două caractere speciale, puteți interzice indexarea oricărei pagini sau secțiuni a site-ului.

Cum să ne asigurăm că am compilat robots.txt corect?

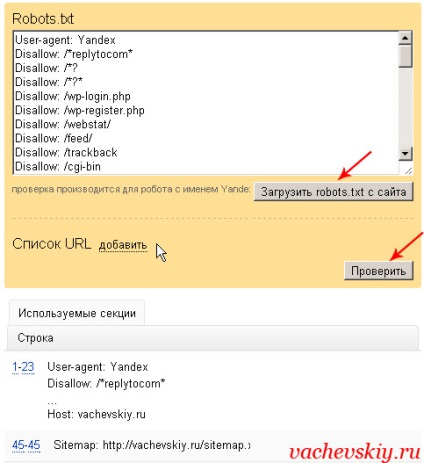

Pentru aceasta, în primul rând, trebuie să adăugați un site la webmaster-ul Yandex. Apoi, trebuie să accesați secțiunea: "Configurarea indexării" - "Analiza robots.txt".

După aceasta, trebuie să descărcați fișierul robots.txt și să faceți clic pe butonul de verificare. Dacă vedeți despre astfel de mesaje ca în imagine, fără erori, atunci aveți robots.txt corect pentru wordpress sau un alt sistem de control.

Dar putem testa în continuare o anumită pagină. De exemplu, copiez URL-ul articolului, care ar trebui să fie deschis pentru indexare, și verific dacă este așa.

Ei bine, apa și totul, probabil, în ceea ce privește întrebarea, cum să creați un fișier txt robots pentru wordpress. Și nu numai pentru wordpress. Acum trebuie să puteți compune robots.txt corecte pentru orice sistem de control.

Articole similare

Trimiteți-le prietenilor: