Bună ziua, astăzi vom vorbi despre cum să creăm txt-ul robotului corect și de ce este necesar.

Ce este robotul txt

Într-unul dintre articolele noastre anterioare, am vorbit de asemenea despre modul în care funcționează roboții de căutare. Fișierul txt robot oferă instrucțiuni pentru a căuta roboți despre cum să indexați corect site-ul. Cu ajutorul directivelor puteți, de exemplu, să-i spuneți robotului ce pagini sau directoare ar trebui indexate și care nu, creați un grup de oglinzi pentru site-ul dvs. (dacă aveți unul), specificați calea spre fișierul sitemap și așa mai departe. În general, este folosit pentru a interzice indexarea anumitor pagini ale site-ului.

Cum se creează txt-ul robotului potrivit

Puneți fișierul finalizat în directorul rădăcină al site-ului dvs. (unde este localizat index.html).

Direcția User-agent

Acesta este un fel de roboți de căutare de salut.

Permiteți și dezactivați

Folosind directiva Disallow, specificați care pagini sau directoare sunt interzise de a fi indexate. Și cu directiva Permite, respectiv, puteți.

O astfel de înregistrare va informa toți roboții de căutare care, din întregul site, pot doar indexa catalogul de directoare.

Iată un exemplu de robot txt cu instrucțiuni pentru instrucțiuni individuale pentru diferite motoare de căutare:

# permite robotului să indexeze întregul site, cu excepția secțiunii cu biciclete

User-agent: *

Nu permiteți: / biciclete /

# interzice robotului să indexeze site-ul, cu excepția secțiunii cu bărci

User-agent: Googlebot

Permiteți: / barci /

Nu permiteți: /

# interzice tuturor celorlalte motoare de căutare să indexeze site-ul

User-agent: *

Nu permiteți: /

Fiți atenți. că nu pot exista linii goale între directivele User-agent, Allow și Disallow!

Simboluri speciale * și $

În directivele Allow și Disallow, puteți folosi caracterele speciale * și $ pentru a specifica expresii regulate. * - selectează secvența specificată

De exemplu: # Împiedică roboții să indexeze toate paginile ale căror adrese URL conțin private

User-agent: *

Dezactivați: / * privat

În mod implicit, la sfârșitul fiecărei reguli, trebuie să specificați caracterul special *. Și pentru a anula * la sfârșitul regulii, se folosește caracterul $.

De exemplu: # dezactivează '/ lock'

# dar nu interzice '/lock.html'

User-agent: *

Dezactivați: / blocați $ # dezactivează și '/ lock'

# și '/lock.html'

User-agent: *

Dezactivați: / blocați

Caracterul $ special nu interzice specificarea * la sfârșit, adică:

User-agent: *

Dezactivați: / blocați $ # dezactivează numai "/ lock"

Nu permiteți: / lock * $ # la fel ca 'Disallow: / lock'

# dezactivează /lock.html și / lock

Directiva sitemap-ului

Dacă utilizați Sitemap, utilizați directiva Sitemap și specificați calea către unul (sau mai multe fișiere) din acesta.

Directiva gazdă

Dacă site-ul dvs. are oglinzi, apoi folosind această directivă, un robot special va forma un grup de oglinzi ale site-ului dvs. și numai oglinda principală va face o căutare. Această directivă nu garantează alegerea sitului specificat în acesta ca oglindă principală, dar îi conferă o prioritate ridicată în luarea unei decizii.

# specificați oglinda site-ului principal

Notă. Această directivă este utilizată exclusiv pentru Yandex! + Pentru fiecare fișier robots.txt este procesată numai o singură directivă gazdă. Dacă sunt specificate mai multe directive în fișier, robotul utilizează primul.

Directiva gazdă trebuie să conțină:

Pot folosi chirilicul în roboți txt?

Nu, nu puteți folosi chirilicul. Pentru a specifica numele de domeniu în limba chirilică, utilizați, de exemplu, acest serviciu.

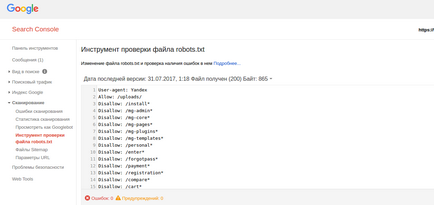

Configurarea robotului txt MogutaCMS

În MogutaCMS, nu este nevoie să completați txt-uri de roboți, deoarece acesta este umplut automat când motorul este instalat.

Articole similare

Trimiteți-le prietenilor: