Înainte de a începe să vorbiți despre duplicate, Alexander a dat definiția unei pagini duplicat a site-ului:

Dublarea - două sau mai multe pagini ale aceluiași site. care conțin conținut de text identic sau suficient de similar.

Motivele pentru apariția duplicatelor pe site sunt numeroase și toate sunt legate de diferite erori. De exemplu:

Erori în conținutul paginilor:

• Referințe relative incorecte

• Lipsa de text

• HTTP-200 în loc de HTTP-404

• disponibilitatea paginilor oficiale

Un mare număr de cauze posibile pentru dubluri, de obicei, foarte oprimat de webmasteri și pune căutarea lor pe termen nelimitat, care nu doresc să piardă timpul pe ea. Nu faceți acest lucru, deoarece prezența paginilor duplicat pe site duce deseori la diverse probleme.

01 | Pericol de duplicate pe site

Problemele duplicate conduc la:

• Modificați pagina relevantă în rezultatele căutării

• ocolirea paginilor duplicat

• Dificultate în colectarea statisticilor

Modificați pagina relevantă

Robotul nu stochează mai multe documente identice în baza de date, astfel încât numai unul dintre ele rămâne în căutare - la discreția robotului. Se pare că nu este nimic în neregulă cu acest lucru, deoarece paginile sunt identice. Cu toate acestea, webmasterii cu experiență știu că poziția unei anumite pagini pe nevoile sunt calculate pe baza mai multor sute de indicatori, astfel încât, dacă modificați pagina în rezultatele căutării, poziția se poate schimba.

După un timp, pagina relevantă a revenit la emitere, dar este clar că chiar și o astfel de modificare mică poate afecta cantitatea de trafic per resursă.

Omiterea paginilor duplicat

Dacă există o mulțime de duplicate pe resursă, robotul de căutare trebuie să viziteze constant un număr mare de pagini. Deoarece numărul de cereri de la robotul de indexare este limitat (producător server sau CMS webmaster site-ul utilizând directiva crawl de întârziere), este, în prezența unui număr mare de pagini duplicat, începe să le descărcați, în locul paginii de index dorit. Ca rezultat, rezultatele căutării pot prezenta unele date irelevante, iar utilizatorii nu vor putea găsi informațiile de care au nevoie, chiar dacă sunt afișate pe site.

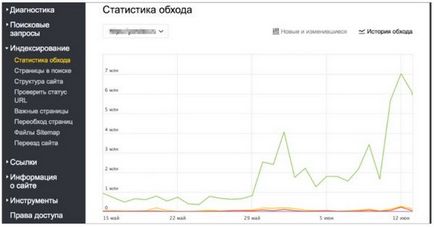

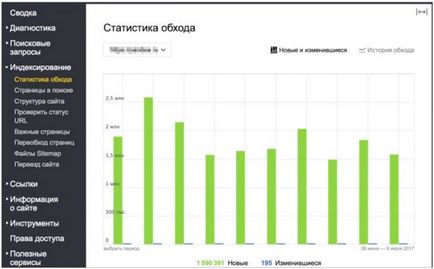

Un exemplu de practică de ocolire a paginilor duplicate, din care este clar că până la sfârșitul lunii mai, robotul a descărcat zilnic un pic mai puțin de un milion de pagini din magazinul online. După actualizarea resurselor și efectuarea modificărilor site-ului, robotul începe brusc să crească încărcarea resursei, descărcând câteva milioane de pagini pe zi:

Cele mai multe dintre aceste pagini sunt duplicate, cu parametri GET incorecți care au apărut din cauza funcționării incorecte a CMS-ului folosit pe site.

Probleme cu colectarea de statistici în Yandex.Vebmaster și Yandex.Metrics

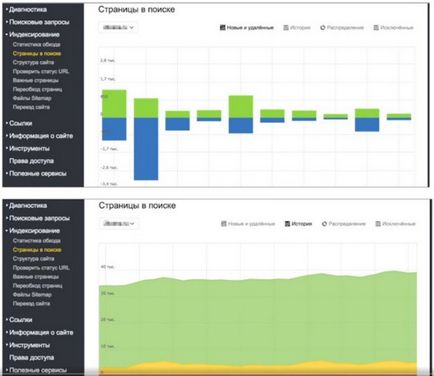

Dacă vorbim despre Webmaster, atunci în secțiunea "Pagini în căutare" puteți vedea această imagine:

Cu fiecare actualizare a bazei de date de căutare, numărul de pagini din căutare rămâne aproape neschimbat, dar este clar că robotul adaugă și elimină aproximativ același număr de pagini cu fiecare actualizare. Adică, se produce un proces, ceva este în mod constant eliminat și adăugat, în timp ce numărul de pagini din căutare rămâne neschimbat. Dacă te uiți la statisticile privind crawlerele, vom vedea că în fiecare zi robotul vizitează câteva mii de pagini noi ale site-ului, în timp ce aceste noi pagini nu sunt incluse în rezultatele căutării. Acest lucru este la fel și este conectat cu robotul ocolind paginile duplicate, care nu sunt incluse în ieșirea de căutare.

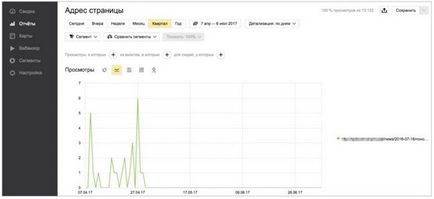

Dacă vedeți statisticile privind prezența unei anumite pagini în Yandex. Metric, poate apărea următoarea situație: această pagină a fost afișată mai devreme pe o anumită solicitare și au existat tranziții din rezultatele căutării care s-au oprit într-un fel la începutul lunii mai:

Și următorul lucru sa întâmplat: pagina duplicat a fost activată în ieșirea de căutare și utilizatorii au început să meargă la ea, în loc de pagina necesară a site-ului.

Se pare că aceste trei mari probleme, cauzate de prezența unor pagini duplicate pe site, ar trebui să motiveze webmasterii să le elimine. Și pentru a elimina duplicatele de pe site, trebuie mai întâi să le găsiți.

02 | Căutați duble

- Vezi pagini duplicate?

- Nu.

- Și nu știu. Și sunt.

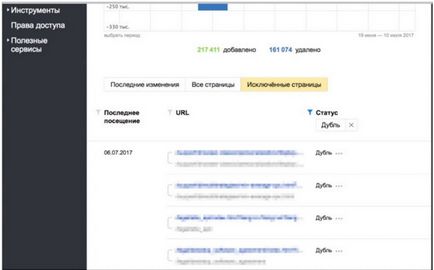

Cea mai ușoară modalitate de a căuta pagini duplicat este folosirea secțiunii "Pagini în căutare" din Yandex Webmaster:

Pagini în căutare -> Pagini excluse -> Sortare: Dublu -> Aplicare

Ca rezultat, puteți vedea toate paginile pe care robotul le-a exclus, numărați-le ca duplicate.

Dacă există multe astfel de pagini, de exemplu, câteva zeci de mii, puteți descărca pagina rezultată de la Webmaster și apoi o puteți folosi la discreția dvs.

Cea de-a doua cale este folosirea secțiunii "Statistics Bypass":

Statistici cu crawlere -> Sortare: 200 (OK)

În această secțiune puteți vedea nu numai paginile vizitate de robot, nu numai duplicate, ci și diverse pagini de servicii ale site-ului pe care nu doriți să le vedeți în căutarea dvs.

A treia cale - cu folosirea imaginației.

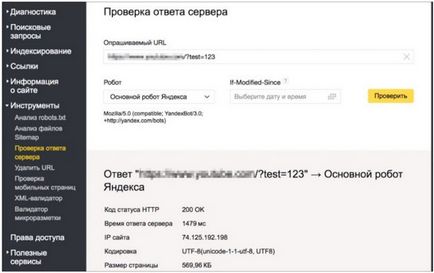

Ia orice pagină a site-ului, și adăugați-l la un GET-parametru arbitrar (în acest caz / încercare = 123 Cu instrumentul „Verificarea răspunsului serverului“, verificați codul de răspuns pe această pagină?.:

Dacă această pagină este disponibilă și răspunde, ca în captura de ecran, cu un cod de răspuns de 200, acest lucru poate duce la apariția de pagini duplicate de pe site. De exemplu, dacă un robot află undeva o astfel de legătură pe Internet, îl va indexa și, eventual, poate deveni un duplicat.

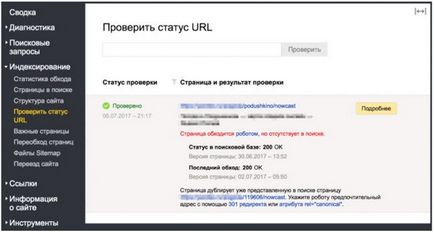

A patra modalitate este de a verifica starea adresei URL.

Într-o situație în care pagina dorită a dispărut deja din rezultatele căutării, cu ajutorul acestui instrument puteți verifica exact ce motive au avut loc:

În acest caz, este clar că pagina a fost exclusă din căutare deoarece este un duplicat.

În plus față de aceste patru metode pot fi utilizate chiar și unele dintre căile sale, de exemplu: a se vedea jurnalele de server, statistici Yandeks.Metriki, în cele din urmă, pentru a vedea rezultatele căutării, este de asemenea posibil pentru a identifica paginile duplicat.

03 | Eliminarea dublelor

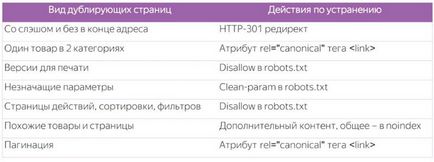

• duplicate explicite (conținut complet identic)

• Duplicate implicite (pagini cu conținut similar)

- redirecționarea HTTP-301 de la un tip de pagină la altul utilizând .hitacces / CMS

Webmasterul însuși decide ce pagini să părăsească pentru robot în fiecare caz în parte. Puteți căuta paginile site-ului dvs. în căutare, care sunt prezente în acesta în momentul de față și puteți lua o decizie pe baza acestor date.

- Folosim atributul rel = "canonical" al etichetei

3. Pagini de versiuni pentru imprimare

4. Pagini cu parametri nesemnificativi

site.ru/page

site.ru/page?utm_sourse=adv

site.ru/page?sid=e0t421e63

Apelam la utilizarea directivei speciale Clean-param în robots.txt și specificați toți parametrii nesemnificativi utilizați pe site -

5. Pagini de acțiune de pe site

site.ru/page?add_basket=yes

site.ru/page?add_compare=list

site.ru/page?comment_page_1

Interdicția în robots.txt -

site.ru/girls / minge

site.ru / jucării / jucării / jucării / jucării / minge

1. Căutarea sursei de apariție

2. Configurați HTTP-404 pentru cererile robotului

7. Produse similare

- Lăsați mărfurile pe o singură adresă URL și folosiți selectorul (capacitatea de a alege culoarea și dimensiunea potrivită)

- Adăugăm pe aceste pagini o descriere suplimentară, recenzii

- Închidere inutilă în noindex

8. Pagini cu fotografii fără descriere

Pagini ale galeriilor foto, fotobancilor

9. Filtrați și sortați paginile

- Determinați relevanța și concediul util

- Pentru inutil scrie o interdictie in robots.txt -

10. Pagini de paginare

site.ru/shop/catalog/podarki/

site.ru/shop/catalog/podarki/?page_1

site.ru/shop/catalog/podarki/?page_2

Folosim atributul rel = "canonical" al etichetei

04 | concluzii:

Cauzele și tipurile de duplicate sunt diverse, deci trebuie să existe abordări diferite față de acestea din punctul de vedere al optimizării căutării. Nu le subestimați. Este adesea necesar să te uiți la Webmaster și să faci schimbări adecvate site-ului în timp util.

Foaie de înșelătorie pentru a lucra cu duble:

Articole similare

Trimiteți-le prietenilor: