În acest articol, un exemplu de cod optim, în opinia mea, pentru un fișier robots.txt în WordPress, pe care îl puteți utiliza în site-urile dvs.

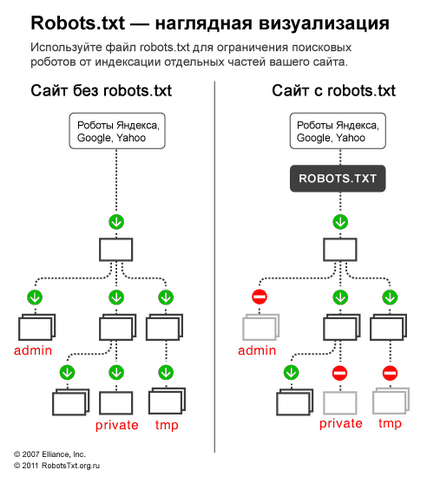

Pentru început, să ne amintim de ce avem nevoie de robots.txt - fișierul robots.txt este necesar exclusiv pentru ca roboții de căutare să "spună" secțiunile / paginile site-ului pe care să le viziteze și care dintre acestea nu trebuie să le viziteze. Paginile închise din vizită nu vor intra în indexul motoarelor de căutare (Yandex, Google, etc.).

Opțiunea 1: cel mai bun cod robots.txt pentru WordPress

În linia User-agent: *, specificăm că toate regulile următoare vor funcționa pentru toate roboții de căutare *. Dacă doriți ca aceste reguli să funcționeze numai pentru un anumit robot, în loc de * specificați numele robotului (User-agent: Yandex, User-agent: Googlebot).

- Dezactivați: / cgi-bin - închide directorul de script-uri de pe server

- Dezactivați: / feed - închide fluxul RSS al blogului

- Dezactivați: / trackback - Închide notificările

- Disallow. s = sau Disallow: *? s = - închide pagina de căutare

- Dezactivați: * / pagina / - închide toate tipurile de paginare

Din documentația Yandex: "Gazdă este o directivă independentă și funcționează oriunde în fișier (inter-partiție)". Așa că am pus-o sau chiar la sfârșitul dosarului, printr-o linie goală.

Acest lucru este important: regulile de sortare înainte de procesare

Yandex și Google gestionează directivele Allow and Disallow nu în ordinea în care sunt specificate, ci mai întâi să le sorteze de la regula scurtă la cea lungă și apoi să proceseze ultima regulă potrivită:

Pentru a înțelege rapid și pentru a aplica funcția de sortare, rețineți această regulă: "Cu cât este mai lungă regula în robots.txt, cu atât mai mare este prioritatea. Dacă lungimea regulii este aceeași, prioritatea este acordată directivei Permite. "

Opțiunea 2: robots.txt standard pentru WordPress

Nu știu cine, dar eu sunt pentru prima opțiune! Deoarece este mai logic - nu completați complet secțiunea pentru a specifica directiva Gazdă pentru Yandex, care este o intersecție (este înțeleasă de robot oriunde în șablon, fără a specifica care robot îi aparține). În ceea ce privește directiva Permisă non-standard. atunci funcționează pentru Yandex și Google și dacă nu deschide dosarele încărcate de alte roboți care nu o înțeleg, atunci în 99% din nimic periculos acest lucru nu se va implica în sine. Nu am observat încă că primii roboți nu funcționează așa cum ar trebui.

Unele roboți (nu Yandex și Google) - nu înțeleg mai mult de 2 directive: User-agent: și Disallow :;

3. Sitemap: o directivă de intersecție pentru Yandex și Google și, aparent, și pentru mulți alți roboți, așa că vom scrie la sfârșit printr-o linie goală și va funcționa pentru toți roboții simultan.

Pe baza acestor corecții, codul corect ar trebui să arate astfel:

Adăugăm la noi înșine

Dacă doriți să închideți orice apariție / știri. apoi scriem:

Puteți afla mai multe despre directivele robots.txt pe pagina de ajutor Yandex (dar rețineți că nu toate regulile descrise acolo funcționează pentru Google).

Crawl-delay - timeout pentru roboți nebun

Când un robot Yandex scanează un site ca nebun și acest lucru creează o sarcină inutilă pe server. Robotul poate fi rugat să "reducă viteza".

Pentru aceasta, utilizați directiva privind întârzierea accesării cu crawlere. Aceasta indică timpul în secunde în care robotul ar trebui să fie în așteptare pentru a scana fiecare pagină următoare a site-ului.

Pentru compatibilitatea cu robotii care respectă prost standardul robots.txt, întârzierea accesării cu crawlere trebuie specificată în grup (în secțiunea User-Agent) imediat după Disallow and Allow

Robotul Yandex înțelege valori fracționare, de exemplu, 0,5 (o jumătate de secundă). Acest lucru nu garantează faptul că crawlerul va vizita site-ul dvs. la fiecare jumătate de secundă, dar va grăbi accesarea cu crawlere a site-ului.

Robotul Google nu înțelege directiva privind întârzierea accesării cu crawlere. Puteți specifica intervalul de timp pentru roboți în panoul webmasterului.

Robots.txt verificare și documentație

Articole similare

Trimiteți-le prietenilor: